HOME | ÍNDICE POR TÍTULO | NORMAS PUBLICACIÓN

HOME | ÍNDICE POR TÍTULO | NORMAS PUBLICACIÓN Espacios. Vol. 37 (Nº 27) Año 2016. Pág. 20

João Bosco LEÃO CARNEIRO 1; Daniel Reis Armond de MELO 2

Recibido: 15/05/16 • Aprobado: 13/06/2016

RESUMO: Atualmente, as organizações buscam tecnologias e ferramentas que proporcionem ganhos de produtividade, como forma de se destacarem no mercado com os produtos ou serviços que fornecem. Este trabalho faz uma introdução aos conceitos envolvidos na tecnologia de virtualização de servidores, dando ênfase aos resultados obtidos com essa ferramenta quando comparados a um ambiente de Tecnologia da Informação tradicional. Com esse objetivo, foi conduzida uma pesquisa bibliográfica sobre o tema, além de entrevistas com um gestor e dois técnicos envolvidos no processo de planejamento, aquisição e implentação de um novo data center, incluindo nesse contexto a implantação e utilização de uma ferramenta de virtualização de servidores. Foram coletadas também informações com usuários externos ao ambiente de TI, que se utilizam dos serviços disponibilizados por este. No caso em questão, a utilização dessa tecnologia mostrou-se satisfatória, uma vez que o objetivo de alcançar melhores níveis de produtividade, com as devidas ressalvas, foi alcançado. |

ABSTRACT: Currently organizations seek technologies and tools that provide productivity gains as a way to stand out in the market with the products or services they provide. This work is an introduction to the concepts involved in server virtualization technology, emphasizing the results obtained with this tool when compared to a traditional Information Technology environment. To this end, a literature search on the topic was conducted, as well as interviews with a manager and two technicians involved in the planning process, acquisition and implentation of a new data center, including in this context the deployment and use of a virtualization tool servers. They were also collected information with users outside the IT environment, which use the services offered by this. In this case, the use of this technology was satisfactory, since the goal of achieving better productivity levels, with the necessary qualifications, has been achieved. |

O conceito de virtualização é hoje uma realidade dentro do ambiente de Tecnologia da Informação - TI das organizações, sejam elas de qualquer porte, de natureza pública ou privada. O que começou como um experimento para melhor aproveitamento da capacidade de processamento dos antigos mainframes (computadores de grande porte), transformou-se em uma poderosa ferramenta para utilização, gerência e monitoramento de recursos computacionais. Nos data centers da área de TI das organizações atuais, o termo “virtual” está associado a um computador que não existe fisicamente, ou seja, uma “máquina virtual”. Muitos imaginam que esse termo surgiu junto com a linguagem de programação Java, por causa das Java Virtual Machines, ou JVMs, mas a verdade é que ele é bem mais antigo e remonta à década de 60. Um dos primeiros fabricantes a implementar a idéia foi a IBM, em seu sistema /370.

Uma máquina virtual nada mais é, portanto, que uma camada de software que oferece um ambiente completo muito similar a uma máquina física. Com isso, cada máquina virtual pode ter seu próprio sistema operacional, bibliotecas e aplicativos (CARISSIMI, 2008, p.65).

Atualmente, a virtualização já é reconhecida como eficiente, eficaz e efetiva no contexto da TI de uma organização. Cabe, no entanto, indagar: um ambiente de TI que faça uso da virtualização leva vantagem quando comparado a um ambiente tradicional, se levados em consideração fatores como disponibilidade de serviços, melhor utilização dos ativos de informática, gestão dos recursos, necessidades de treinamento e custos?

No caso particular de um data center, essas questões justificam-se pelo fato de algumas novidades tecnológicas trazerem muita euforia pelas promessas que apresentam inicialmente. Algumas, com o tempo, não ratificam os benefícios que aparentavam trazer, outras, no entanto, consolidam-se e tornam-se pela prática reconhecidas como confiáveis, permanecendo no mercado. Para se ter uma idéia da importância dada ao principal componente de TI das organizações, o planejamento estratégico da Universidade de São Paulo (USP), por exemplo, deixa claro que:

No atual ambiente de TI o Data Center é um componente central de missão crítica. É, portanto, indispensável que seja concebido para oferecer os serviços da Universidade de maneira flexível e dinâmica, acompanhando as tendências tecnológicas e de sustentabilidade hoje exigidas. Os projetos devem considerar a elaboração de infraestrutura física padronizada, escalável e segura, provendo níveis de redundância e virtualização. (USP, 2011, p.1).

Reconhecida pela organização, no presente caso uma instituição pública de ensino superior, a importância da TI para a consecução de seus objetivos, nesse aspecto, a principal questão a ser respondida é se é possível obter ganhos de produtividade com a tecnologia de virtualização de servidores no data center, levando-se em conta, como já mencionado, fatores como disponibilidade de serviços, melhor utilização dos ativos de informática, gestão dos recursos, treinamento de pessoal e custos.

Com o objetivo principal de verificar a pertinência da utilização da tecnologia de virtualização em servidores, o trabalho está estruturado nas seguintes seções: Introdução, que abrange o contexto, o problema e as possíveis respostas; Referencial teórico, onde é realizada a revisão da literatura necessária à discussão do tema e à apresentação de resultados pertinentes à questão de pesquisa; Metodologia, onde serão detalhadas as etapas da pesquisa assim como as fontes de dados pesquisadas e o caminho percorrido na construção de possíveis respostas; Resultados e discussão, onde a referência principal são os objetivos da pesquisa, assim como as possíveis respostas a cada um deles e; Considerações finais, onde com base nos resultados, serão apontados caminhos para futuras pesquisas sobre o tema.

O termo “virtual” é empregado hoje em contextos distintos e com uma série de significados e associações com outros termos que dão margem a uma gama de interpretações. Quando se fala em “realidade virtual”, por exemplo, a idéia que se tem é de jogos eletrônicos que levam os usuários a mundos e cenários antes inimagináveis. Virtual pode estar relacionado também a sistemas e equipamentos que simulam fatos ou ações do mundo real, como os simuladores de vôo, por exemplo, que são uma excelente ferramenta para o aprendizado e certificação dos profissionais da área da aviação.

Singh (2004, apud Ramos, 2009), descreve virtualização com sendo a ferramenta ou metodologia de dividir os recursos de um computador em múltiplos ambientes de execução, através da aplicação de um ou mais conceitos ou tecnologias como hardware e software de particionamento, compartilhamento de tempo, simulação de máquina parcial ou completa, emulação, qualidade de serviço, e outros.

Caciato (2010) afirma que a virtualização, numa definição livre, “é o processo de executar vários sistemas operacionais em um único equipamento”, o que era impossível antes do surgimento dessa tecnologia. Uma máquina virtual é um ambiente operacional completo que se comporta como se fosse um computador independente. Com a virtualização, um servidor pode manter vários sistemas operacionais em uso, simulando vários servidores, cada um deles executando serviços distintos. Se o conceito parece complexo, é só imaginar que o computador presente hoje em muitas residências, apesar de ser fisicamente um só, poderia, com a virtualização, ser dividido em vários computadores virtuais.

A virtualização foi desenvolvida na década de 1960 para criar partições dos hardwares grandes de mainframes (computadores de grande porte, centralizados) a fim de obter uma melhor utilização. Hoje, os computadores baseados na arquitetura x86 (os PCs usados em casa) enfrentam os mesmos problemas de rigidez e subutilização dos mainframes dos anos 60 (VMware, 2012). Ou seja, a tecnologia evoluiu mas isso não resolveu por si só a questão da subutilização de recursos.

Para exemplificar, existem hoje computadores pessoais com processadores de 8 cores (núcleos de processamento), memória principal de vários gigabytes e espaço para armazenamento de alguns terabytes, nos quais roda apenas um sistema operacional, normalmente Windows ou Linux. Ou seja, na prática, o equipamento possui recursos que terão quase sempre um baixíssimo nível de utilização, o que representa um grande desperdício.

Com a virtualização, cada máquina virtual além de ter seu próprio sistema operacional, pode ter também aplicativos e serviços de rede (acesso à internet, por exemplo). É possível ainda interconectar (virtualmente) cada uma dessas máquinas através de interfaces de rede, switches, roteadores e firewalls virtuais (CARISSIMI, 2008, p.173).

Mas virtualização em TI vai muito além do compartilhamento de processador, memória ou espaço em disco. Nesse sentido, ela pode ser definida como uma “técnica que combina ou divide recursos computacionais para prover um ou mais ambientes operacionais de execução”. Os ambientes criados através dessa técnica são chamados máquinas virtuais (CRISTÓVÃO et ali, 2009, p.3).

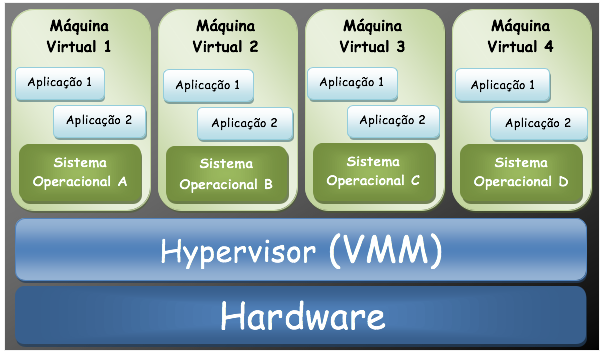

De acordo com Mattos (2008), em um ambiente virtualizado existe a definição de dois conceitos principais: o de sistema operacional hospedeiro e o de sistema operacional visitante. O sistema operacional hospedeiro (Host Operating System) diz respeito ao sistema operacional nativo da máquina na qual ocorre a virtualização, ou seja, este é o sistema operacional que é executado diretamente sobre o hardware físico. O segundo, o sistema operacional visitante (Guest Operating System), refere-se ao sistema operacional que é executado sobre o hardware virtualizado, ou seja, o sistema operacional que é executado na máquina virtual. Uma máquina física na qual é utilizada a virtualização pode contar com apenas um sistema operacional hospedeiro sendo executado por vez. No entanto, podem ser executados diversos sistemas operacionais visitantes simultaneamente. Isso pode ser visualizado mais adiante, na Figura 1.

Segundo King (2003, apud Cristóvão et ali, 2009), Monitores de Máquinas Virtuais (VMMs, em inglês) podem ser classificados de várias maneiras. Uma delas refere-se à quão perto a interface de que elas provem está do hardware subjacente. Monitores de máquinas virtuais como o VMware ESX Server (um dos mais utilizados softwares de virtualização) apresentam uma abstração de hardware idêntica ao hardware subjacente. Parece impossível chegar a um nível de abstração tão alto, mas alguns monitores inserem no sistema operacional-hospedeiro drivers de dispositivos que serão usados pelo sistema operacional-visitante através do VMM. Já outros VMMs apresentam uma interface diferente do hardware subjacente. A máquina virtual Java, por exemplo, tem uma arquitetura totalmente independente do hardware sobre o qual executa.

A figura 1 representa um servidor físico, no qual foi implantado um software de virtualização. Nele, a camada de virtualização representada pelo hypervisor (VMM), interage diretamente com o hardware (o equipamento físico, propriamente dito) e coloca os recursos deste à disposição dos servidores virtuais. Estes, por sua vez, dispõem de seu próprio sistema operacional e de suas aplicações, cada um independente do outro.

Figura 1 - Representação de um servidor físico virtualizado

Fonte: elaboração própria (2015)

De acordo com Carissimi (2009), basicamente existem duas formas de implementação de máquinas virtuais de sistema ou hipervisores. Os hipervisores tipo I, são aqueles que executam diretamente sobre o hardware de uma máquina real e as máquinas virtuais são instaladas sobre ele. A função básica de um hipervisor desse tipo é compartilhar os recursos de hardware (processador, memória, meios de armazenamento e dispositivos de entrada/saída) entre as diferentes máquinas virtuais de forma que cada uma delas tenha a ilusão de que esses recursos são privativos a ela. Esse tipo de hipervisor corresponde ao originalmente implementado nos sistemas IBM no início da década de 70. Atualmente, o Xen e o VMware ESX Server são exemplos de hipervisores que adotam essa abordagem. Segundo o mesmo autor, os hipervisores tipo II, são caracterizados por executar sobre um sistema operacional nativo como se fossem um processo deste. Nesse caso, o que o hipervisor oferece nada mais é que uma camada de virtualização composta por um sistema operacional hóspede, possivelmente diferente do sistema operacional nativo, e por um hardware virtual criado sobre os recursos de hardware oferecidos pelo sistema operacional nativo. São exemplos dessa abordagem o Vmware Player, o VirtualBox e o MS VirtualPC 2007.

Em um ambiente de virtualização, os dispositivos de armazenamento virtual não estão restritos às limitações de capacidade, velocidade ou confiabilidade dos dispositivos físicos que os incluem. O provisionamento consiste em fornecer aos usuários ou aplicações a quantidade e o melhor tipo de armazenamento, no momento certo, algo parecido com o conceito de Just in Time (JIT). A virtualização torna muito mais fácil esse processo. Somada à administração centralizada, permite que modificações na camada de armazenamento físico sejam efetuadas sem a interrupção do acesso aos dados, a fim de fornecer, ininterruptamente, a melhor qualidade de serviços de armazenamento em tempo real (CRISTÓVÃO et ali, 2009, p.6).

Além disso, o conceito de virtualização pode ser aplicado não só aos subsistemas, tais como discos, mas a uma máquina inteira. Como já foi observado, para implementar uma máquina virtual, desenvolvedores adicionam uma camada de software a uma máquina real para suportar a arquitetura desejada. Ao fazer isso, a máquina virtual pode contornar problemas de compatibilidade com a máquina real e restrições de recursos de hardware (SMITH; NAIR, 2005, p.33).

De acordo com uma pesquisa realizada pelo IDC (International Data Corporation) em 2007, a virtualização está a caminho de se tornar uma prática padrão entre as mil maiores empresas do mundo, listadas no ranking Fortune 1.000. Segundo dados do centro de pesquisa em tecnologia Forrester Research, mais de 40% das empresas norte-americanas já abraçaram a tecnologia (CRISTÓVÃO et ali, 2009, p.6).

Stocco e Pereira (2010), apontam dados fornecidos por grandes multinacionais, como a Microsoft Corporation e a Sun Microsystems, que através de estudos realizados quanto à utilização média de data centers, chegaram a um resultado comum de 5% a 15%. Ou seja, consolidar a fatia restante de recursos é economicamente interessante tanto da visão comercial quanto técnica, sem contar outros benefícios. No exemplo dado, há uma enorme fatia não utilizada de recursos, algo em torno de 85 a 90%, ou seja, desperdício em alta escala.

Em outra pesquisa, Seruya (2013) relata que sem o uso da virtualização há desperdícios da ordem de 80 a 90% no uso de discos, memória e processador dos equipamentos.

Para Bigelow (2013), o atributo mais interessante de uma plataforma de hardware virtual talvez seja sua versatilidade, porque um administrador pode ajustar os níveis de cada recurso, adicionando mais memória e outros núcleos de processador, alocando outro disco virtual ou atribuindo mais portas de adaptador de rede, por exemplo. O aumento dos níveis de recursos normalmente melhora o desempenho ou a capacidade de resposta da carga de trabalho, especialmente em servidores físicos mais antigos, ou permite que a máquina virtual suporte mais usuários.

Com a virtualização é possível manter estações virtuais rodando aplicações redundantes, permitindo que, no caso de falha em um ambiente, o outro seja utilizado como recurso de contingência. Com o apoio de ferramentas apropriadas, é possível ainda mover estações virtuais para hardwares diferentes em caso de um problema físico, evitando assim a perda de produtividade e continuidade de serviços. De acordo com dados da VMware, a virtualização, combinada à consolidação de servidores, reduz em até 53% os custos com hardware e 79% os custos operacionais, gerando uma economia média de até 64% para a empresa que adota a solução (CRISTÓVÃO et ali, 2009, p.7).

Adicionalmente, a virtualização aprimora a eficiência do data center por aumentar a quantidade de serviços executados ou diminuir a quantidade de máquinas físicas necessárias para a mesma quantidade de serviços. Assim, considerando constante a quantidade de serviços, pode reduzir o uso de espaço. A busca por melhorias nos data centers bem como a ânsia por proporcionar a seus clientes, usuários e gestores uma organização correta, segura e consistente incentiva fortemente a busca pela virtualização (SILVA et ali, 2008, p.3).

A aposta nas soluções de virtualização deriva da necessidade dos gestores de tecnologia da informação em conceder uma resposta eficaz ao aumento e à diversificação dos ambientes computacionais e aos sistemas informatizados dentro das organizações. Além disso, a adequada gestão do Custo Total de Propriedade (Total Cost of Ownership - TOC) é cada vez mais relevante, bem como a capacidade de solucionar as crescentes dificuldades de manutenção e de gestão desses mesmos ambientes (CRISTÓVÃO et ali, 2009, p.6).

Essas perspectivas de melhoria, no entanto, não podem ser tomadas como verdade irrefutável, pois conforme relatado na edição de outubro/2011 da revista Computerworld

Torna-se importante gerir a ruptura com a situação anterior e não criar expectativas irrealistas. É preciso saber minimizar o risco e garantir o desempenho durante a implantação, a qual envolve em grande parte dos casos uma renovação de máquinas. Noutras vezes, esquece-se a formação dos gestores de TI, crucial para usufruir dos benefícios em pleno. Algumas empresas prescindem dessa formação como forma de reduzir custos, enquanto outras, em menor número, levantam a hipótese de se libertarem dos próprios recursos humanos (COMPUTERWORLD, 2011, p.1).

A observação da revista Computerworld é pertinente e realista nos dois aspectos citados: a garantia da continuidade dos serviços durante a implantação e, principalmente, a questão da formação do pessoal técnico, que é fator essencial para uma utilização plena dos recursos da virtualização.

2.2.1 Vantagens da virtualização

Entre as vantagens apontadas por alguns dos principais defensores da virtualização, estão (SILVA et al, 2008):

2.2.2 Desvantagens da virtualização

Em contrapartida, entre as desvantagens apontadas com a adoção da virtualização estão (MATTOS et al, 2008; CARISSIMI, 2008):

Vale lembrar, a propósito, a observação da revista Computerworld, que o investimento em formação, o conhecimento e o planejamento sobre a implantação da tecnologia são fatores essenciais para evitar resultados não esperados.

A pesquisa, realizada na área de TI, mas com foco no uso de ferramentas para obter ganhos de produtividade, baseou-se na experiência de uso da tecnologia de virtualização de servidores posta em prática no Centro de Tecnologia da Informação e Comunicação - CTIC da Universidade Federal do Amazonas (UFAM).

O CTIC iniciou suas atividades, ainda como Centro de Processamento de Dados (CPD), no ano de 1975, ocupando espaço modesto, divido com outro setor da Instituição, em um prédio da UFAM no centro de Manaus. O primeiro equipamento de computação utilizado foi um IBM /3, cuja capacidade de processamento não se compara hoje ao mais modesto dos computadores pessoais. Desse período para cá, avanços substanciais ocorreram na informática, e isso, consequentemente, ocorreu também no ambiente de TI da UFAM. Esses avanços, entre outros fatores, foram ocasionados pelos resultados de pesquisas na área da microeletrônica e, principalmente pelo aumento exponencial da demanda por serviços de informática. Como uma instituição pública de ensino superior, a UFAM não fugiu a essa regra e teve que investir cada vez mais nessa área.

Quanto aos objetivos a pesquisa pode ser classificada como descritiva. De acordo com Gil (2008), as pesquisas descritivas possuem como objetivo a descrição das características de uma população, fenômeno ou de uma experiência. A grande diferença entre esta e a pesquisa exploratória é que o assunto já é conhecido. A pesquisa descritiva traz, no entanto, novas perspectivas ao tema abordado.

Quanto aos procedimentos metodológicos é uma pesquisa bibliográfica e um estudo de caso (o CTIC da UFAM). Gil (2008) relata que a pesquisa bibliográfica é aquela desenvolvida com base em material já elaborado, constituído principalmente de livros e artigos científicos.

A pesquisa se desenvolveu na forma de pesquisa bibliográfica e através de entrevistas exploratórias, além de experimentos práticos na área em questão. O objetivo foi coletar informações na literatura, nos textos oriundos do projeto de modernização do data center da UFAM e nas entrevistas com um gestor e dois Analistas da área TI, além dos experimentos práticos realizados com a ferramenta de virtualização no próprio ambiente do data center.

A entrevista exploratória, segundo Quivy e Campenhoudt (2005), tem como função principal revelar determinados aspectos do fenômeno estudado em que o investigador não teria espontaneamente pensado por si mesmo e, assim, completar as pistas de trabalho sugeridas pelas suas leituras. Isso vem de encontro aos objetivos da pesquisa, de não buscar apenas conceitos pré-estabelecidos e afirmações das empresas que produzem os softwares de virtualização, mas comparar experiências e opiniões daqueles que fazem uso prático da tecnologia. Segundo os mesmos autores “As entrevistas exploratórias não têm como função verificar hipóteses nem recolher ou analisar dados específicos, mas sim abrir pistas de reflexão, alargar e precisar os horizontes de leitura, tomar consciência das dimensões e dos aspectos de um dado problema, nos quais o investigador não teria decerto pensado espontaneamente” (QUIVY; CAMPENHOLDT, 2005, p.69). É justamente essa possibilidade de colher informações que estão nas entrelinhas, no conhecimento tácito e experiências não-formalizadas que se torna importante nesse tipo de investigação.

Além disso, foram colhidas também informações com usuários comuns dos serviços oferecidos pelo CTIC/UFAM, escolhidos de forma aleatória em vários setores da Instituição. Essa coleta de informações “externas” ao CTIC objetivou uma comparação com a percepção dos técnicos envolvidos no contexto da virtualização.

A aplicação de entrevistas semi-estruturadas com o gestor e com analistas do CTIC envolvidos na experiência de planejamento, implantação e gerenciamento da ferramenta de virtualização, ocorreu em virtude da necessidade de obter informações que permitissem responder ao objetivo da pesquisa, qual seja, aferir se houve ganhos de produtividade nas tarefas internas e nos serviços oferecidos pelo órgão em função do uso da tecnologia. A entrevista com o gestor da área, especificamente, busca informações de caráter gerencial, relativas à gestão e à relação do órgão com outras áreas da Instituição. O foco da entrevista com os analistas é, evidentemente, obter informações de caráter mais técnico, relacionadas à experiência vivida com o planejamento, a pesquisa, as aquisições, enfim, todas as etapas percorridas até alcançar o nível de virtualização hoje existente.

Após a coleta de informações na pesquisa bibliográfica e nas entrevistas, o passo seguinte foi efetuar experiências práticas no ambiente do data center, a fim de poder quantificar os resultados obtidos pelo CTIC, na busca por uma tecnologia que permitisse ganhos de produtividade e melhorias nos serviços oferecidos à comunidade da qual é parte integrante. Essa etapa contou com o apoio dos próprios analistas do CTIC, e nela foram realizados procedimentos práticos utilizando a ferramenta de virtualização VMware. Entre outros, foram realizados os seguintes testes, cujos resultados serviram como referência para a pesquisa:

O objetivo desta etapa foi buscar informações no próprio ambiente de produção do data center, sem as quais não seria possível obter resultados satisfatórios para a pesquisa.

Com base nas informações coletadas, objetivou-se, através da descrição da experiência do CTIC, comprovar a pertinência da utilização da tecnologia de virtualização de servidores como um fator relevante na melhoria da produtividade e, consequentemente, dos serviços prestados à comunidade da UFAM.

Para uma melhor compreensão do assunto, o conceito de servidor aqui deve ser sempre entendido como um equipamento de informática que disponibiliza serviços a vários usuários (clientes) ao mesmo tempo. Esses serviços podem ser correio eletrônico, bancos de dados, sistemas corporativos, páginas web, compartilhamento de arquivos, entre outros. Como o tipo de serviço disponível em um servidor interfere diretamente em sua maior ou menor complexidade, a tabela 1 mostra algumas diferenças.

Tabela 1 - Tipos de servidores de acordo com a complexidade

|

Servidor tipo 1 |

Servidor tipo 2 |

Servidor tipo 3 |

Serviços disponibilizados |

Correio eletrônico Banco de dados Sistema corporativo (SIE) Sistema de telefonia (VOIP) DNS DHCP Firewall |

Páginas web da UFAM Sistema de Bibliotecas Sistema de Restaurante Redmine FTP Moodle |

Compartilhamento de arquivos Compartilhamento de impressão |

Complexidade |

Alta |

Média |

Baixa |

Impacto no negócio |

Máximo |

Médio |

Mínimo |

Fonte: elaboração própria (2015)

Convém observar que a complexidade deriva não apenas das dificuldades de criação, configuração ou recuperação do servidor, mas principalmente de seu impacto na continuidade do negócio da Instituição. No caso do servidor que abriga o principal sistema corporativo (SIE), por exemplo, que é utilizado por praticamente todos os setores da UFAM, uma falha é algo que deve ser evitado. Isso ocorre também em relação aos servidores que mantém a Internet em funcionamento (DNS, DHCP, Firewall).

É importante lembrar que a complexidade é um fator a ser considerado quando há necessidade de recuperação de um servidor, pois ela interfere diretamente na dificuldade da tarefa. Em função disso, a complexidade foi sempre levada em consideração quando da realização dos testes práticos.

Todas as etapas descritas anteriormente, tem o objetivo evidente de responder às questões elencadas anteriormente, associando a implantação da tecnologia de virtualização a aspectos tais como: disponibilidade de serviços, melhor utilização dos ativos de informática (ou consolidação de servidores), gestão dos recursos, necessidades de treinamento e custos.

Os primeiros passos para a virtualização de servidores no Data Center em questão, começaram como uma experiência dos técnicos de TI, ávidos por colocar em prática uma nova ferramenta sobre a qual haviam tomado conhecimento. Após o primeiro contato, animados por informações obtidas em sites especializados sobre o assunto e relatos de experiências em outros data centers, decidiu-se virtualizar, em nível de teste, alguns poucos servidores nos quais executavam aplicações não-críticas.

Nesse período, era comum nos anos 2008-2010, artigos publicados desaconselhando o uso da virtualização para alguns aplicativos críticos, como bancos de dados, por exemplo. Entre as justificativas estava a de que esses aplicativos consumiam muitos recursos de máquina e que isso sobrecarregaria o servidor físico. Não deixa de haver razão no cuidado em relação à virtualização de servidores de bancos de dados, dada a importância dos mesmos, mas com os novos recursos desenvolvidos pelos fabricantes tanto de hardware quanto de software, essa preocupação deixou de fazer sentido. Com o surgimento dos servidores tipo lâmina (blades), dos modernos dispositivos de armazenamento (storages) e dos novos recursos presentes nas ferramentas de virtualização, os responsáveis pelos data centers passaram a vislumbrar novas perspectivas nas possibilidades de virtualização. A própria Oracle, um dos maiores fabricantes de software de banco de dados do mundo, disponibilizou uma distribuição do sistema operacional linux dedicada ao seu banco de dados, o Oracle Linux. E não há nele nenhuma restrição à virtualização.

No caso específico do data center do CTIC da UFAM, a experiência de virtualização dos primeiros equipamentos foi satisfatória, o que ensejou o aumento do número de servidores virtualizados. A primeira ferramenta de virtualização utilizada, nessa ocasião, foi o XEN, um software de distribuição gratuita. Entre as dificuldades encontradas na utilização da ferramenta estavam a falta de uma interface gráfica e, evidentemente, a inexistência de qualquer treinamento para os técnicos envolvidos. Nesse período, o data center da UFAM ocupava um prédio no Setor Sul do Campus Universitário (o Campus da UFAM é dividido em dois setores) e estava em andamento o processo de mudança para um novo espaço no Setor Norte do Campus. Paralelo a isso, um grupo de técnicos e o gestor do CTIC iniciaram a elaboração de um projeto (Projeto Data Center/2009) que visava a construção de um novo data center para dotar a UFAM de recursos de TI que atendessem a crescente demanda por serviços de informática. O projeto foi aprovado e o novo data center construído e aparelhado com equipamentos de última geração, incluídos aí servidores tipo blade, storage para armazenamento de dados, robot de backup, servidores de telefonia VOIP, switches com módulos de fibra ótica de 10 Gbps, além de outros.

Esse upgrade de recursos de informática encorajou a equipe do CTIC a solicitar também a aquisição da ferramenta de virtualização. O software escolhido foi o VMware Vsphere, que já estava sendo usado em sua versão de testes gratuita, e que segundo os técnicos, quando comparado com outros era o que apresentava melhores recursos e facilidades de uso, devido à familiaridade já existente. De acordo com os próprios técnicos e o gestor do CTIC envolvidos no projeto, esse foi um passo natural, uma vez que os equipamentos instalados no novo data center eram totalmente compatíveis e até os mais indicados ao propósito da virtualização de servidores. Ou seja, se já haviam sido realizados testes satisfatórios utilizando os servidores antigos, com os novos equipamentos a tendência seria de melhoria. Mesmo porque os novos servidores adquiridos estavam entre os recomendados pelos fabricantes do software de virtualização.

Em relação ao fator disponibilidade de serviços, na opinião do gestor do CTIC, segundo ele baseada em relatórios da própria ferramenta, a virtualização certamente trouxe ganhos (algo em torno de 25%), pois “agilizou a manutenção desses serviços, possibilitando um percentual maior de disponibilidade dos mesmos”.

Quando a mesma questão foi feita em relação à produtividade dos técnicos envolvidos, o gestor argumentou que “a virtualização trouxe facilidades para a criação de novos serviços e manutenção dos serviços existentes, agilizando atividades operacionais e possibilitando que os técnicos fiquem focados em ações mais estratégicas”. Quando questionado sobre a economia relacionada à aquisição de equipamentos, custos com energia elétrica e treinamento de pessoal, o gestor afirmou que por possibilitar a concentração de diversos serviços em uma única máquina física, “é possível afirmar com 100% de segurança que a virtualização gera significativa economia em relação à aquisição de equipamentos e com custos de energia elétrica”.

Na questão do treinamento de pessoal técnico, há dificuldades, uma vez que não existem na cidade (Manaus) cursos técnicos nessa área, e a capacitação, nesse caso, é de extrema importância para o uso adequado da ferramenta de virtualização. Além disso, a contratação de serviços de treinamento pela Instituição para qualificação de seus técnicos nem sempre é um processo fácil, pelos mais diversos motivos, entre eles o custo.

Na relação com os objetivos do Setor, o gestor reitera que a implantação da virtualização está totalmente alinhada aos objetivos do CTIC, inclusive na questão ambiental, uma vez que essa tecnologia está em concordância com esses valores e esse é também um dos princípios do referido setor. Ele enfatiza, inclusive, que a virtualização atende a estratégia do Plano de Desenvolvimento Institucional da UFAM, na questão da modernização dos serviços prestados à comunidade universitária.

Na visão dos técnicos (analistas) envolvidos no processo, obter ganhos de produtividade com relação à consolidação de servidores é um fato. Segundo eles, isto porque com a virtualização o processo torna-se extremamente mais rápido e seguro. Rápido porque existem ferramentas no software de virtualização que permitem a migração de uma máquina física para virtual em poucos passos; e seguro porque sempre existe a possibilidade de testar um servidor antes de colocá-lo em produção. No que diz respeito à eficiência na utilização dos equipamentos, houve unanimidade em afirmar que esse é um dos principais aspectos onde os ganhos de produtividade são indiscutíveis. Inclusive isso corrobora afirmação de Stocco e Pereira (2010), quando citam dados de pesquisa de grandes multinacionais de que a utilização média dos recursos em um data center convencional é de 5 a 15%.

Para os entrevistados, é evidente que se existem n servidores com uma taxa de utilização x, de forma que x < 100%, é menos custoso e muito mais vantajoso consolidar os n servidores em apenas um, com taxa de utilização de n.x, desde que n.x < 100%. Entenda-se servidor, neste caso, como o equipamento físico (hardware). A segunda relação é, evidentemente, muito mais eficiente e econômica.

No que diz respeito às atividades dos técnicos, os analistas afirmam que ela se torna muito mais produtiva, primeiro porque simplifica muitas tarefas antes demoradas e enfadonhas, segundo porque permite que o pessoal tenha tempo para outras atividades, inclusive de planejamento e capacitação. Os técnicos ressaltam, no entanto, que todos têm que estar muito bem preparados para a utilização plena da ferramenta, caso contrário a ocorrência de erros pode comprometer todo o ganho obtido. Em função disso, é evidente que há uma demanda de treinamento dos técnicos, e esse é um dos “gargalos” do processo.

Na visão desses técnicos, a questão da disponibilidade dos serviços também melhora muito com a virtualização, dada a facilidade com que é possível colocar novamente em atividade um servidor com problemas, ou mesmo criar um servidor para um novo serviço. Sem contar que a gestão dos recursos do data center se torna muito mais simples, em virtude da tecnologia unificar toda a gerência em uma única tela de monitoramento (interface). Para eles, o processo de virtualização também é vantajoso em relação aos custos, principalmente pela diminuição da quantidade de servidores físicos, dos requisitos de refrigeração de ar e, conseqüentemente, de energia elétrica.

Na opinião de usuários consultados em vários setores da Instituição, as melhorias nos serviços do CTIC após o início do uso da virtualização (2010/2011) também foram visíveis. Esses usuários relataram, entre outras coisas, melhorias efetivas no acesso aos sistemas institucionais (disponibilidade), serviço de email, download de arquivos e acesso à Internet de uma forma geral. Essas informações, coletadas junto a usuários alheios ao ambiente de TI, ratificam as afirmações do pessoal técnico do CTIC e comprovam, na visão deles, a eficácia e eficiência da tecnologia de virtualização neste caso específico.

Os testes práticos realizados no ambiente do data center abrangeram os tópicos elencados na seção 3 (metodologia) e estão diretamente relacionados aos objetivos da pesquisa, quais sejam: disponibilidade de serviços, consolidação de servidores, gestão dos recursos, necessidades de treinamento e custos. Para coleta das informações referentes aos testes, foi utilizada a própria ferramenta de monitoramento e gerência do software de virtualização, o Vcenter.

O aspecto disponibilidade implica em que os servidores permaneçam disponíveis aos usuários sem interrupção dos serviços. De acordo com a tabela 1, os servidores que mais causam impacto são os do tipo 1, portanto, esse quesito é de suma importância no data center da Instituição. Nesse tipo de servidores, estão hospedados, por exemplo, serviços como correio eletrônico, bancos de dados, sistemas corporativos (recursos humanos, material e patrimônio, controle acadêmico, protocolo, entre outros) e o acesso à Internet. Assim sendo, o ideal é que a disponibilidade desses servidores esteja sempre acima de 95%.

Para ilustrar esse aspecto, a tabela 2 mostra os valores considerados para níveis de alta disponibilidade, onde o downtime é o tempo de indisponibilidade no período.

Tabela 2 - Níveis de alta disponibilidade

Disponibilidade (%) |

Downtime/ano |

Downtime/mês |

95 |

18 dias 6:00:00 |

1 dias 12:00:00 |

96 |

14 dias 14:24:00 |

1 dias 4:48:00 |

97 |

10 dias 22:48:00 |

0 dias 21:36:00 |

98 |

7 dias 7:12:00 |

0 dias 14:24:00 |

99 |

3 dias 15:36:00 |

0 dias 7:12:00 |

99,9 |

0 dias 8:45:35.99 |

0 dias 0:43:11.99 |

99,99 |

0 dias 0:52:33.60 |

0 dias 0:04:19.20 |

99,999 |

0 dias 0:05:15.36 |

0 dias 0:00:25.92 |

Fonte: elaboração própria (2015)

Com relação a esse quesito, a tabela 3 mostra os percentuais alcançados nos testes realizados no data center do CTIC-UFAM. Nesse aspecto, deve ser levado em conta que a ferramenta de monitoramento do software de virtualização “avisa” sobre a ocorrência de qualquer anormalidade com um servidor, tornando mais simples a identificação e correção do problema.

Tabela 3 - Testes realizados em servidores considerando a disponibilidade de serviços

|

Servidor virtualizado |

Servidor convencional |

Disponibilidade média (%) |

98 |

< 95 |

Período de tempo considerado |

30 dias |

30 dias |

Tempo de indisponibilidade |

08:34:00 hs |

2 dias |

Fonte: elaboração própria (2015)

Com a finalidade de ilustrar a importância da disponibilidade de servidores, um dos principais órgãos de controle do Governo Federal Brasileiro, a Controladoria Geral da União (CGU) em seu Plano Estratégico de Tecnologia da Informação - Triênio 2013/2015, estabeleceu como metas de disponibilidade, para sistemas e serviços corporativos críticos, os percentuais de 90%, 95% e 98%, respectivamente.

No quesito consolidação de servidores, que implica em uma melhor utilização dos ativos de informática, ou seja, do hardware dos equipamentos, houve ganhos ainda maiores com a implantação da virtualização. Isso pode ser visualizado na tabela 4.

Tabela 4 - Testes realizados considerando a consolidação de servidores

|

Servidor virtualizado |

Servidor convencional |

Utilização média de recursos (%) |

90 a 95 |

15 a 20 |

Período de tempo considerado |

30 dias |

30 dias |

Ganho alcançado (%) |

75 |

- |

Fonte: elaboração própria (2015)

Quando se leva em conta a questão da gestão dos recursos, entendida como a capacidade de utilizar e gerenciar eficientemente os recursos materiais disponíveis no data center, os testes com a ferramenta de gerência do VMware, o Vcenter, comprovaram sua versatilidade. Em uma interface única, ela possibilita, entre outras coisas, monitorar os servidores em produção; criar modelos (templates) de servidores; criar cópias (snapshots) de servidores em plena atividade; alterar recursos de servidores (processador, memória, espaço em disco, etc.); criar e recuperar backups de servidores virtuais inteiros e; mover servidores virtuais de um equipamento para outro.

Fazer balanceamento de carga entre servidores físicos pode ser feito automaticamente pelo software, basta que seja configurado. Da mesma forma, os backups de servidores podem ser agendados para ocorrer no horário mais adequado, para que o impacto seja mínimo na performance dos sistemas.

Para se ter uma idéia da diferença, foi realizado um teste de recuperação de um servidor de baixa complexidade que apresentou problemas. Com a ferramenta de backup do VMware, o servidor foi recuperado em aproximados 20 minutos. Sem o uso da virtualização, o tempo aproximado foi de 8 horas para entregar o servidor totalmente operacional.

A consolidação de servidores e a gestão de recursos estão inversamente ligados à questão da necessidade de treinamento e custos. Pelo que já foi apresentado, é possível deduzir que após os custos iniciais com a implantação da virtualização, em seguida haja uma redução decorrente do melhor aproveitamento dos recursos, do espaço físico, das necessidades de refrigeração de ar e, consequentemente, de energia elétrica. Essa redução impacta também no tempo de resolução de problemas pelos técnicos e na disponibilidade dos serviços aos usuários, o que reflete em um melhor desempenho para além do ambiente do CTIC.

Se for levado em consideração, no entanto, a questão das necessidades de treinamento, haverá um acréscimo inicial. Isso se explica pelo fato de a tecnologia de virtualização ser complexa por natureza. A simplicidade da interface única de gerência não significa que tudo é simples. Erros de configuração ou de manuseio podem levar a desastres que a tecnologia justamente se propõe a evitar. Cabe, portanto, à Instituição e a área de TI especificamente, o planejamento adequado de suas necessidades de capacitação de pessoal, para que este não venha a ser um entrave para a modernização.

Se por um lado há certa euforia por parte de um maior contingente dos usuários da virtualização de servidores, incentivada pelos fabricantes das soluções, por outro há aqueles que olham com cautela essa tecnologia. Simpatizantes e contrários à parte, o mais coerente em um contexto onde se busca melhoria de produtividade, é tratar a questão com a seriedade e o profissionalismo necessários, buscando informações e experiências já vivenciadas que dêem suporte o mais confiável possível à iniciativa.

Atualmente, já existe razoável quantidade de literatura sobre a tecnologia de virtualização, e nela é possível comprovar que há uma grande maioria de defensores e um número bem menor de críticos. Isso se deve, como já visto, aos evidentes recursos trazidos pela tecnologia, como constatado na opinião daqueles que a utilizam no dia-a-dia. Há questões, que estão elencadas anteriormente no texto entre as desvantagens, que merecem atenção. As mais contundentes são as que dizem respeito a treinamento de pessoal e custos envolvidos. No primeiro caso, devido ao já citado “problema crônico do fraco investimento em formação...” e, como confirmado pelos técnicos entrevistados, essa questão é de suma importância, devido à crescente necessidade de pessoal qualificado para utilizar todos os recursos encontrados nas ferramentas de virtualização. Esse fator não pode menosprezado, dado ao alto investimento inicial feito em equipamentos e softwares, o que pressupõe um uso racional dos recursos disponíveis. Em função disso, a questão dos custos, a despeito de sua eventual redução com o uso da virtualização, é bastante crítica, dado que o investimento inicial é alto e que sempre existem contingências. Assim sendo, em uma decisão de implantar virtualização, deve-se sempre levar em conta que recursos existem, mas que tem que ser planejados, justificados, liberados, bem aplicados e comprovados na sua utilização, o que nem sempre é fácil.

Neste caso específico, os técnicos do CTIC aproveitaram a ocasião da mudança de local e elaboraram o projeto do data center incluindo nele vários recursos modernos de hardware e software, incluindo a ferramenta de virtualização. O investimento justificou-se plenamente pela evidente necessidade de expansão, para atender a crescente demanda de serviços de TI da UFAM. Pelo que foi abordado na pesquisa, os recursos financeiros foram bem empregados, pois sua aplicação foi baseada em pesquisa e planejamento elaborados por técnicos da área. Constatou-se também, com base na literatura, no conteúdo das entrevistas e nos testes realizados que a tecnologia de virtualização se mostrou capaz de atender as necessidades do CTIC e, além disso, proporcionou ganhos de produtividade nos serviços prestados pelo órgão.

Com relação ao que foi apresentado, é interessante apontar como caminhos para futuros trabalhos na área, uma investigação mais aprofundada quanto aos custos envolvidos especificamente com relação à implantação da virtualização, pois no caso do CTIC da UFAM ela se deu concomitantemente com a construção do novo data center. Outra abordagem interessante seria com relação a capacitação de pessoal, levando-se em conta os custos, o quantitativo de pessoal, os processos e o ambiente de trabalho na área de TI.

BIGELOW, S.J. Virtualização de servidores: Visão geral de especialistas sobre custos, tendências e muito mais. Guia Eletrônico, in SearchServerVistualization.com, acesso em 20/29/2013.

CARISSIMI, A. Virtualização: da Teoria a Soluções. 26º Simpósio Brasileiro de Redes de Computadores e Sistemas Distribuídos. Instituto de Informática - Universidade Federal do Rio grande do Sul. 26 a 30 de maio de 2008, Rio de janeiro.

______________. Virtualização: Princípios Básicos e Aplicações. Artigo apresentado no Encontro Regional de Alto Desempenho - ERAD, realizado no período de 17 a 20 de março de 2009. Universidade de Caxias do Sul.

COMPUTERWORLD. Virtualização de Servidores. Outubro 2011, Lisboa.

CONTROLADORIA GERAL DA UNIÃO. Plano Estratégico de Tecnologia da Informação - Triênio 2013-2015. CGU-DSI. Brasília, 2012.

CTIC-UFAM. Projeto Data Center. Elaborado pela equipe de técnicos da área de suporte do CTIC da Universidade Federal do Amazonas. Versão 1.0, ver. 8, 2009.

CRISTÓVÃO A.M; GUIRAU, J.C.N; WEN, T.C; COSTA, I; SPINOLA, M. A. Virtualização como um Instrumento de Apoio à Disponibilidade de Redes de Computadores. Artigo apresentado no XXIX Encontro Nacional de Engenharia de Produção. Salvador, BA, 06 a 09 de outubro de 2009.

GIL, A.C. Como elaborar projetos de pesquisa. 4. ed. São Paulo: Atlas, 2008.

GOMES, M.M; FACALOSSI, W.F. Máquinas Virtuais. Curso de Sistemas de Informação. Faculdade de Ciências Aplicadas “Sagrado Coração”. Linhares, 2007.

MATTOS, D.M.F. Virtualização: VMWare e Xen. GTA/POLI/UFRJ, 2008. Disponível em http://www.gta.ufrj.br/publicacoes/. Acesso em 12/08/2013.

QUIVY, R; CAMPENHOUDT, L. Manual de Investigação em Ciências Sociais. Lisboa: Gradiva, 2005.

RAMOS, J.C.C.S. Security Challenges With Virtualization. Mestrado em Segurança de Informática (Dissertação). Departamento de Informática, Universidade de Lisboa, 2009.

SERUYA, Francisco Cintra Lobo e Távora. A virtualização como factor multiplicador da competitividade e eficiência das organizações. Dissertação de Mestrado em Gestão. Universidade Lusíada de Lisboa, 2013.

SILVA, A.J; TRASSI, R.B; SILVA, Y.M; COELHO, F.S; PORTO, J. Implantação da virtualização nos servidores da Universidade Federal do ABC - UFABC: um estudo do caso. Artigo apresentado no XV Simpósio de Engenharia de Produção. Bauru, SP, 10 a 12 de novembro de 2008.

SMITH, J.E; NAIR, R. The Architecture of Virtual Machines. Computer. IEEE Computer Society, 2005.

STOCCO, F; PEREIRA, J.C. Virtualização de Sistemas Operacionais. Universidade Paranaense (UNIPAR), Paranavaí, PR, Brasil.

USP. Planejamento Estratégico 2011-2014: Parte 3 - Infraestrutura de Data Center. Universidade de São Paulo, 2011.

VMWare. História da Virtualização. Disponível em http://www.vmware.com/br/virtualization/virtualization-basics/history.html. Acesso em 12/08/2013.

1. Mestrando em Engenharia de Produção Profissional pela Universidade Federal do Amazonas (2016). MBA em Gestão da Qualidade Total pela Universidade Federal do Amazonas (2013). Especialista em Gestão de Instituições Públicas de Ensino Superior pela Escola Nacional de Administração Pública - ENAP em convênio com a Universidade Federal do Amazonas - UFAM (2009). Graduado em Letras - Língua Portuguesa pela Universidade Federal do Amazonas (1987). Possui 30 anos de experiência na área de Tecnologia da Informação. Exerce a função de Analista de TI na Coordenação de Infraestrutura de Redes do Centro de Tecnologia da Informação e Comunicação - CTIC, da Universidade Federal do Amazonas - UFAM. jcarneiro@ufam.edu.br

2. Doutor em Administração pela Universidade Federal da Bahia (2012). Mestre em Engenharia de Produção (2006) e bacharel em Administração pela Universidade Federal do Amazonas (2002). Atualmente é Professor Adjunto da Universidade Federal do Amazonas. Tem experiência na área de consultoria empresarial, atuando principalmente nas seguintes áreas: Gerenciamento de Projetos, Gestão da Inovação e Sistemas de informação. Em 2013 recebeu o Prêmio CAPES de Tese na área de Administração, Ciências Contábeis e Turismo com a tese "Relação universidade-empresa no Brasil: o papel da academia em redes de coinvenção”. daniel.armond@gmail.com