Vol. 40 (Nº 23) Año 2019. Pág. 16

Vol. 40 (Nº 23) Año 2019. Pág. 16

HERNÁNDEZ, Mario 1; TIGRERO, Freddy E. 2 y RUIZ, Yuri 3

Recibido: 11/04/2019 • Aprobado: 24/06/2019 • Publicado 08/07/2019

RESUMEN: Con el objetivo de determinar el carácter predominante en la evaluación del aprendizaje practicada en la Universidad, se encuestaron 1988 estudiantes, profesores y evaluadores. Se calcularon los porcentajes de medias y varianzas, utilizando el software IBM SPSS versión 22 y se calculó los Alpha de Cronbach; se hizo una triangulación de fuentes y un análisis documental amplio. Los resultados mostraron consistencia, con gran similitud entre las valoraciones de los estudiantes y evaluadores. Se concluyó que la evaluación posee carácter tradicional. |

ABSTRACT: With the objective of determining the predominant character in the evaluation of the learning practiced in the University, 1988 students, professors and evaluators were surveyed. The percentages of means and variances were calculated, using the software IBM SPSS version 22 and the Cronbach's Alpha was calculated; a triangulation of sources and a broad documentary analysis were made. The results showed consistency, with great similarity between the evaluations of the students and evaluators. It was concluded that the evaluation has a traditional character. |

Este trabajo presenta un estudio efectuado por miembros del Proyecto MEVALAP, sobre la evaluación del aprendizaje efectuado en la Universidad Estatal Península de Santa Elena (UPSE), en Ecuador, teniéndose por objetivo determinar si en esta predominaba un carácter tradicional o formativo, a partir de considerar veinte indicadores preestablecidos. De esta manera, se brinda a la comunidad académica estudiosa de este tema, resultados empíricos que pueden ayudar a fundamentar la necesidad de accionar por la mejora de la práctica evaluativa que implementan habitualmente los docentes.

En su evolución histórica, la evaluación del aprendizaje ha atravesado por distintas etapas, modelos, tendencias y prioridades (Escudero, 2003; Mora, 2004). Durante este tiempo, han coexistido dos tipos o concepciones: la sumativa y la formativa. El predominio de una u otra, determina si esta tiene o no carácter tradicional (Anijovich, 2017; Gómez, Monjas, Gómez, López, & Martín, 2006).

Las concepciones formativas presuponen el desarrollo de procesos evaluativos que tienen como objetivo, valorar los procesos y resultados del aprendizaje de los estudiantes desde una perspectiva integral, que ve en dicho proceso una vía que sirve a todos para aprender y mejorar, mediante una dinámica participativa, abierta, democrática y flexible que permite implementar variados métodos y técnicas evaluativas e instrumentos para la recogida de una amplia información, que sirve de retroalimentación, para ajuste de la enseñanza y la mejora de todos los participantes (González, 2000; Hamodi & López, 2012).

Se comprende, que en tal sentido la evaluación formativa está más interesada en las cualidades que en las cantidades; en el desarrollo de habilidades y los avances que muestra el estudiantado, y no sólo en los resultados académicos que a modo de producto acabado, se suelen reportar en los informes de cierre de períodos y que cuestionablemente se ha identificado históricamente como rendimiento académico.

De no ser así, la evaluación posee un carácter tradicional, dejando de responder a las demandas socio-educativas actuales y los desafíos establecidos en las metas de la UNESCO para el año 2021 (Martín & Martínez, 2008; Vaillant & Rodríguez, 2018).

No obstante los avances que reportan en muchos trabajos publicados, sigue siendo esta un área donde persisten las dificultades y siguen pendientes de solución varios problemas (Hernández, 2017; Hernández & Mola, 2016; Muskin, 2015; Pérez, Mora, Triana, & Garzal, 2015; Rodríguez-Espinosa, Restrepo-Betancur, & Luna-Cabrera, 2016).

Aún hay carencia de una cultura de la evaluación que haga preocuparse por la mejora de dicho proceso, partiendo de investigaciones empíricas de tipo diagnósticas, que permitan indagar en las dificultades y sus causas, para comprender lo que ocurre y poder brindar las ayudas necesarias al profesorado (Pérez et al., 2015).

En este sentido, es importante considerar, que con frecuencia muchos profesores no tienen una suficiente formación pedagógica y que con frecuencia muchos llegan a adquirir su titulación sin haber tomado cursos sobre evaluación (Green, Smith, & Brown, 2007), hecho este que también ocurre en el Ecuador y otros países (Heras, 2017; Moscoso & Hernández, 2015).

Los estudios diagnósticos sobre la evaluación del aprendizaje, permiten conocer qué sucede en el proceso, cuáles son las falencias y cuáles son las concepciones, pensamientos e ideas que sustentan la práctica evaluativa que desarrolla el profesorado (Contreras, 2010; Prieto & Contreras, 2008).

Favorablemente, se observa que en los últimos cinco años, han aparecido investigaciones enfocadas en conocer cómo valoran los profesores su práctica evaluativa y cuáles son las percepciones de sus estudiantes sobre esta (Alvarado & Nuñez, 2018; Martínez, Santos, & Castejón, 2017; Rodríguez-Espinosa et al., 2016; Romero, Castejón, & López, 2015; Suárez-Villao, Domínguez, & Gallegos, 2018), las cuales constituyen un precedente valioso para este trabajo. Sin embargo no todas estudian el proceso global a partir de indicadores, que permiten identificar en detalles los aciertos y fallas conceptuales y prácticas en diferentes pasos fundamentales del proceso por parte del colectivo docente.

Los resultados de estas indican, que si bien hay ciertas mejoras en la evaluación, aún siguen muchas prácticas ancladas en concepciones tradicionales, evidenciando su fuerte arraigo.

Un estudio reciente en el Ecuador, efectuado por un experto y consultor de una ONG (Van der Bijl, 2015), se consideraron como “ausencias significativas” que: “no se evalúan, por ejemplo: las estrategias de enseñanza y de aprendizaje (…); la articulación teoría-práctica en la carrera”, enfatizando que: “los procesos son una especie de caja negra en el modelo de evaluación (p. 11), aún y cuando el Ministerio de Educación Superior ha establecido ciertas pautas y estándares que deberían cumplirse en cada nivel educativo (MEE, 2017).

Así mismo, en las búsquedas realizadas se observa que en Ecuador son escasos los trabajos publicados y proyectos de investigación que informen de forma amplia y detallada, sobre las características predominantes en la práctica evaluativa que habitualmente es efectuada por los profesores.

Por todo lo referido, se decidió desarrollar un estudio diagnóstico de la evaluación del aprendizaje en la Universidad Estatal Península de Santa Elena (UPSE) apoyado en veinte indicadores, como parte del Proyecto MEVALAP-UPSE en fase exploratoria, en cual colabora un equipo multidisciplinar de profesores interesados en mejorar el proceso evaluativo.

Varios autores (Feu, Simó, Serra, & Canimas, 2016; Hernández, 2006) han considerado que el empleo de indicadores permite establecer un marco teórico que favorece la objetividad y la validez de los resultados y de los análisis respectivos. Estos se reconocen como variables o aspectos que pueden revelar las cualidades o los rasgos del proceso de evaluación del aprendizaje que es practicado.

La Universidad Estatal Península de Santa Elena, es una institución de la Educación Superior (IES) ecuatoriana, ubicada en la costa del pacífico. Cuenta con veinte años de existencia. Al inicio fue conformada básicamente por maestros que provenían de la enseñanza media y del bachillerato, muchos de los cuales eran ingenieros que, a pesar de disponer algunos de cierta experiencia en contextos educativos, la mayor parte no habían tenido una formación pedagógica. Si bien es cierto que muchos se han capacitado y realizado maestrías en temas de la didáctica y la pedagogía, aún se perciben falencias en el ejercicio evaluativo.

Por otra parte, no se conoce de algún estudio sobre la evaluación del aprendizaje que se haya efectuado en tal amplitud y profundidad en la universidad.

Se asumió un enfoque mixto, dada la complementariedad, flexibilidad e integralidad que ofrece en la investigación (Blanco & Pirela, 2016). Se emplearon métodos teóricos como el análisis-síntesis y la inducción-deducción para analizar la bibliografía. El análisis documental efectuado incluyó los programas docentes, temarios evaluativos e informes del desempeño docente emitidos por la Unidad Operativa de Acreditación (UNOPAC, 2017).

Se aplicaron además, varios métodos empíricos: observación participante en los procesos áulicos; encuestas cerradas empleando escala tipo Likert, con adecuación a tres opciones (nunca, en ocasiones y siempre), que incluyeron veinte ítems o indicadores preestablecidos.

Los resultados de las encuestas calculados, fueron tabulados con la herramienta Excel de la Microsoft; calculándose los porcientos, medias y varianzas de los datos obtenidos a partir de las respuestas dadas por los estudiantes, profesores y evaluadores áulicos, con empleo del software IBM SPSS Statistics, versión 22, con lo que fue posible hacer el procesamiento estadístico necesario.

Se sometió dicho instrumento y en tanto los indicadores asumidos, a una validación de contenido (Escobar-Pérez & Cuervo-Martínez, 2008), para asegurar la conceptualización y la validez del constructo, tomándose en cuenta distintos trabajos previos (González, 2000; Hernández, 2006; Leyva, 2010). Igualmente, los valores obtenidos de los Alpha de Cronbach calculados, también fue considerado como criterio de fiabilidad y consistencia, siguiéndose pautas de otros autores (González Alonso & Pazmiño Santacruz, 2015; Virla, 2010).

Los resultados obtenidos fueron interpretados y razonados en sus particularidades y sus regularidades, en un proceso de construcción y generalización, conjugándose los resultados cualitativos y el procesamiento estadístico realizado (Cuenya & Ruetti, 2010; Ramos, 2015).

Posteriormente se llevó a cabo la triangulación de las fuentes (los tres grupos de actores y participantes en el proceso evaluativo), utilizando los datos salidos de las encuestas, con el propósito de contrastar la información y asegurar la validez de la investigación (Gorina & Alonso, 2017; Teddlie & Tashakkori, 2011).

Se tomaron muestras aleatorias representativas de la población de las tres fuentes o actores: de estudiantes del 3er y 4to semestre, de los docentes y de evaluadores áulicos que evaluaron clases en ese período (año 2017), referido en la Tabla II.

Tabla II. Relación de las fuentes, poblaciones y muestras tomadas en el estudio.

Fuentes |

Población |

Muestra |

Porciento (%) |

Estudiantes |

4530 |

1700 |

23,5 |

Docentes |

278 |

239 |

85,9 |

Evaluadores áulicos |

68 |

49 |

72,0 |

Se tomaron estudiantes de estos semestres, porque en este nivel ya estos han tenido experiencias evaluativas suficientes, han recibido cursos de Metodología de la Investigación y porque luego de un tiempo apropiado, estos alumnos ya en semestres superiores, podrán ser nuevamente encuestados para valorar qué tanto y en qué indicadores ha mejorado la evaluación del aprendizaje que es practicada por sus profesores y valorar el al progreso relativo logrado o por lograrse.

Todas las encuestas fueron válidas, ninguna fue descartada por alguna confusión respecto al contenido, por pérdida o error de datos.

El instrumento tipo encuesta cerrada, fue aplicado a los tres grupos de participantes en el proceso de evaluación: estudiantes, profesores y evaluadores áulicos. Esta contenía los mismos veinte indicadores (Tabla 1), con el fin de recoger valoraciones de fuentes distintas sobre los mismos aspectos del proceso evaluativo desarrollado considerados, empleando la escala: nunca, en ocasiones y siempre.

Tabla 1

Indicadores empleados en las encuestas a

estudiantes, profesores y evaluadores áulicos

1 |

Se definen los objetivos a evaluar en el proceso de enseñanza-aprendizaje. |

2 |

Se socializan los criterios e indicadores de evaluación considerados al evaluar. |

3 |

Se aclaran los fines que se persiguen en las diferentes evaluaciones. |

4 |

Se brinda orientación sobre los contenidos de aprendizaje que evaluarán y en qué profundidad |

5 |

Se propicia la transparencia de las calificaciones con argumentos claros. |

6 |

Se informa y argumentan las estrategias y metódicas evaluativas a emplearse |

7 |

Las evaluaciones se centran en comprobar, verificar y medir lo aprendido |

8 |

Las evaluaciones aplicadas ayudan a mejorar el estudio y potencian el aprendizaje |

9 |

La evaluación busca obtener información amplia y profunda para elaborar juicios evaluativos. |

10 |

Las evaluaciones están en función de la retroalimentación (hay Feedback) |

11 |

El proceso evaluativo efectuado tiene un efecto educativo en los estudiantes. |

12 |

Se evalúan los contenidos temáticos impartidos según se ha trabajado en las clases. |

13 |

Se evalúan los procedimientos y las habilidades puestas en acción por los estudiantes |

14 |

Se evalúan las actitudes y los valores demostradas por los estudiantes. |

15 |

Se evalúa los métodos de estudios, los progresos y avances respecto al punto de partida. |

16 |

Las actitudes, procedimientos y métodos evaluativos estimulan el estudio de la asignatura |

17 |

Las evaluaciones que efectúan, son predominantemente de aplicación y creativas |

18 |

Se emplean variadas técnicas e instrumentos para evaluar. |

19 |

Se aplican evaluaciones integradoras (sobre distintos temas, asignaturas y otras disciplinas). |

20 |

La calificación se efectúa en base a criterios e indicadores definidos y antes establecidos. |

Elaboración propia

Estos indicadores contienen aspectos que están relacionados a las concepciones evaluativas y su aplicación, tomados de propuestas fundamentadas existentes (Hernández, Villarroel, & Zambrano, 2019).

Los resultados obtenidos del cálculo de los Alpha de Cronbach en función de las varianzas de los 20 indicadores que fueron empleados (20 ítems), se muestran en la Tabla 2.

Tabla 2

Coeficientes Alpha de Cronbach obtenidos a partir de las varianzas

calculadas de los 20 indicadores (ítems) para las tres fuentes

Fuente |

Cantidad de encuestados |

Alpha de Cronbach |

Estudiantes |

1070 |

0,943 |

Docentes |

239 |

0,890 |

Evaluadores |

49 |

0,885 |

Elaboración propia

Como puede notarse, los valores correspondientes a docentes y a estudiantes están entre el intervalo de 0,80 y 0,89 (es satisfactorio o adecuado). El de los alumnos en particular, está por encima de 0,90 (entre 0,90-1.00 se considera muy adecuado o muy satisfactorio), lo que equivale a un resultado considerado fiable y portador de una consistencia interna del instrumento, extensible a los ítems o indicadores utilizados.

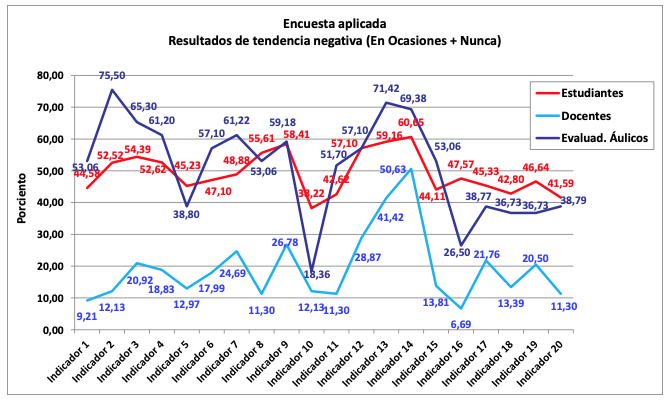

Aunque en principio se hizo un estudio por escalas separadas en cada grupo o fuente, luego se agruparon los resultados enmarcados “en ocasiones + nunca”, para enfocar el análisis en aquellas valoraciones que revelaban en alguna medida insuficiencias o insatisfacciones que fueron expuestas por los actores encuestados, lo que se consideró como revelaciones de tendencias negativas. Los porcentajes de estos resultados se muestran en la figura 1.

Figura 1

Comportamiento de los porcientos correspondientes a cada indicador (ítem) a partir

de las valoraciones emitidas por tres grupos de actores o fuentes de información

Fuente: Elaboración propia

Del análisis efectuado de estos resultados pueden destacarse algunas regularidades:

Los mayores porcentajes de las valoraciones “en ocasiones + nunca”, son entendidos como resultados desfavorables o negativos; esto fue observado en los indicadores 2, 3, 7, 9, 12, 13, 14 y 15 (presentados en Tabla I), lo que significa que en estos aspectos no se alcanzan los logros deseados, evidenciándose rasgos que no corresponden con los preceptos de la evaluación formativa y por el contrario, son típicas de un proceso evaluativo tradicional.

Así, por ejemplo, en los indicadores 2 y 3, relativos a la orientación dada por los docentes a los estudiantes sobre los objetivos a evaluar y los criterios que se asumen, los resultados, develan una insuficiente atención o una poca sistematicidad en el accionar del profesorado sobre este aspecto, a pesar de estar normado por el Reglamento Nacional de la Evaluación Estudiantil (CES, 2016).

De esto se deduce una insuficiente transparencia en el proceso evaluativo, correspondiente a la dimensión ética de la evaluación, lo cual de acuerdo con varios autores (Cabra-Torres, 2010; Orostegui, Lastre Amell, & Gaviria García, 2015), se revela cuando no existe una debida orientación y comunicación clara, no se obra correctamente u ocultan intenciones y fines colaterales, lo que genera un desconcierto o incertidumbres en el estudiantado que atenta contra el clima de confianza y el efecto educativo necesario.

Así mismo, los altos porcentajes en negativo observados en los indicadores 7 y 9, relativos a las funciones de la evaluación y la variedad de técnicas evaluativas empleadas (dimensión metodológica-instrumental), evidencia una estrechez práctica que limita o atenta contra las funciones formativas más relevantes de la evaluación, como son potenciar el aprendizaje, desarrollar las diversas habilidades intelectuales y profesionales y atender las diferencias individuales (González, 2000).

Un resultado semejante fue obtenido en otros estudios que fueron efectuados en países de Latinoamérica (Hernández & Mola, 2016) y en el espacio educativo europeo, donde se señala que frecuentemente “la evaluación se utiliza para comprobar los conocimientos de los estudiantes, estando más orientada a los resultados que a los procesos” (Ibarra & Rodríguez, 2010, p. 395).

Las insuficiencias en la dimensión metodológica-instrumental de la evaluación se revelan de modo puntual en esta investigación, en los resultados reflejados en los indicadores 12, 13 y 14, donde se deja ver una escasa variedad de técnicas evaluativas y una tendencia a evaluar contenidos casi exclusivamente mediante exámenes escritos, algo que ha sido criticado con suficientes fundamentos por varios especialistas, por los efectos negativos generados en el aprendizaje y el estado emocional de los estudiantes (Barriga-Díaz, 2013; Ureña, 2016). Se puede inferir por tanto, que suele evaluarse de la forma que es más fácil evaluar: tradicionalmente.

Este hecho, permite deducir que las evaluaciones en general están poco enfocadas hacia las habilidades, los procedimientos y las actitudes puestas en acción por los estudiantes, lo que impide indagar cómo aprenden y actúan los alumnos o en qué aspectos poseen mayores dificultades y necesitan más ayuda, algo que no concuerda con una evaluación integral y formativa real (Hernández, 2015; Hernández & Mola, 2016).

Algunos especialistas han señalado que este tipo de dificultades, pone en cuestionamiento el tipo de enseñanza practicada y el modo en que se enseña (Guerra, 2003; Monereo & Lemus, 2010), toda vez que la evaluación es parte del proceso de enseñanza-aprendizaje y es uno de sus componentes didácticos.

Estudios realizados en Latinoamérica (Ravanal, López-Cortés, & Rodríguez, 2018; Renes & Martínez, 2016; Yunga-Godoy, Loaiza, Ramón, & Puertas, 2016), incluido en el Ecuador (Estupiñán, Carpio, del Rocío, & Romero, 2016), dejan ver que el enfoque tradicional de la enseñanza y las metódicas reproductivas frecuentemente implementadas, comprometen el logro real de aprendizajes significativos y duraderos, donde está involucrada la evaluación.

El comportamiento de los resultados globales obtenidos de las encuestas, puede apreciarse además a partir de las medias generales calculadas que se muestran en la Tabla 3.

Tabla 3

Medias generales en orden decreciente de los indicadores

correspondientes a los tres grupos evaluados

Indicadores |

Media General |

10 |

2,73 |

16 |

2,68 |

18 |

2,64 |

20 |

2,62 |

5 |

2,59 |

17 |

2,59 |

19 |

2,58 |

1 |

2,56 |

15 |

2,53 |

11 |

2,52 |

8 |

2,48 |

6 |

2,47 |

2 |

2,44 |

4 |

2,43 |

3 |

2,43 |

7 |

2,42 |

9 |

2,40 |

12 |

2,39 |

13 |

2,28 |

14 |

2,26 |

Fuente: Elaboración propia

Aun y cuando el indicador 19, referido a la aplicación de evaluaciones integradoras, no aparece dentro de los que presentan mayor dificultad, tampoco la excluye (ver figura 1), lo cual puede ser una señal de que la enseñanza practicada puede estar careciendo de un carácter integrador suficiente. Situaciones así, han sido objeto de preocupación, de análisis y de investigación en varios trabajos publicados (Salgado, Bauza, & González, 2017).

Esto constituye una alerta en el contexto educativo ecuatoriano, donde precisamente se pone énfasis en incrementar el carácter sistémico-integrador del currículo y el aprendizaje, y se orienta implementar proyectos integradores de saberes (SNNA. SENESCYT, 2013).

Por otra, parte los valores de las medias calculadas para cada fuente: estudiantes (49,26), evaluadores (51,04), y docentes (19,33), deja ver más definidamente otro hecho: mientras que los alumnos y evaluadores concuerdan notablemente en sus valoraciones, no ocurre así con los profesores.

Se interpreta, que mientras que los profesores valoran su propia práctica evaluativa muy favorablemente, los estudiantes tienen otra percepción de la misma. Hechos semejantes han sido observados en otros estudios efectuados en los que se han sido contrastadas ambas fuentes o actores (Arribas & Estebaranz, 2017; Hamodi, López, & López, 2015).

Pudiera suponerse, que los profesores sobrevaloran su ejercicio evaluativo o que se han manifestado de una forma acrítica consigo mismos. También pudieran considerarse, que los alumnos no tienen conocimientos de didáctica o pedagogía y que no poseen criterios para efectuar una valoración técnicamente justa. Sin embargo, como indica el sugerente título de un interesante artículo (Rodríguez, Ibarra, Gallego, Gómez, & Quesada, 2012), “la voz del estudiante en la evaluación del aprendizaje es un camino aún por recorrer” (p. 1), tomar en cuenta la opinión del estudiantado, para los cuales se enseña, es válido y resulta ser un mecanismo retroalimentador necesario para la mejora del desempeño de los profesores.

En los últimos tiempos se ha podido notar que en varias investigaciones y ensayos (Hidalgo & Murillo, 2017; Ricoy & Femández-Rodríguez, 2013; Rodríguez-Espinosa et al., 2016), se ha tomado en cuenta la percepción y la valoración de los estudiantes, de los que en general se obtienen criterios honestos y razonables. Justamente, los alumnos deben participar en el proceso evaluativo “desde su diseño hasta las conclusiones” (Trillo & Porto, 1999, p. 57)

Dentro de las principales dificultades observadas, están:

Con frecuencia hay falta de correspondencia entre los resultados de aprendizaje que se prevén obtener, y los métodos de enseñanza seleccionados y las evaluaciones que son planteadas en los programas o sílabos, no ajustándose a las habilidades rectoras que se prevén desarrollar: fundamentar, conceptualizar, caracterizar y otras.

Escasa variedad de técnicas evaluativas planificadas, empleándose predominantemente del examen escrito. Muy pocas veces son contemplados otras como el portafolio, los diarios reflexivos o los mapas mentales y conceptuales, que permiten desarrollar y evaluar con mayor validez y efectividad el desempeño, las relaciones significativas entre los conceptos fundamentales, los procedimientos y actitudes del estudiantado.

Se observó que:

Con frecuencia las preguntas evaluativas que se plantean poseen algunas dificultades de redacción, quedando poco claras o ambiguas y no se emplean muchas veces los mismos términos que están reflejados en los programas o sílabos, en correspondencia con las habilidades rectoras que se desean evaluar: describa, argumente, explique y otras.

Las preguntas evaluativas suelen ser de respuesta corta, de clasificar, de selección o de falso y verdadero, lo cual no favorece el desarrollo cognitivo, la experimentación activa (EA) y reflexiva (ER), ni permite evaluar de modo apropiado las habilidades intelectuales y procedimentales de los estudiantes, quedando regularmente al nivel reproductivo o memorístico (Castaño, Ramos, & García, 2017).

De acuerdo con algunos autores (Godoy, 2015), esta situación supone una “escasa incorporación de aspectos de interacción didáctica en las evaluaciones docentes” (p. 59), lo cual puede impedir mejorar la calidad de la educación y el nivel de los aprendizajes de los estudiantes.

El análisis del informe emitido por la Unidad Operativa de Acreditación (UNOPAC, 2017), a partir de las evaluaciones del desempeño de los docentes en los períodos 2017-1 y 2017-2, dejó ver igualmente la existencia de varias dificultades de carácter metodológico reveladas en las clases, que no excluyen a la evaluación del aprendizaje, hecho este que incluso fue tomado en cuenta para la elaboración del plan de capacitación anual de los docentes por parte de las autoridades académicas.

La observación de estas dificultades a partir del análisis documental efectuado, concuerda con los resultados obtenidos de las encuestas, lo cual aporta fiabilidad y refuerza la validez de la triangulación efectuada.

Se puede concluir que el proceso de evaluación del aprendizaje desarrollado en la Universidad Estatal Península de Santa Elena, Ecuador, posee rasgos tradicionales, que no corresponden a los preceptos educativos actuales que se desean.

Los indicadores que dejaron ver mayores dificultades o falencias están relacionados fundamentalmente a las dimensiones ética, la de funcionalidad y a la metodológica-instrumental, que pueden relacionarse a deudas en las concepciones del profesorado que sustentan la praxis.

Mediante la triangulación (contrastación) de las fuentes o actores, se pudo observar notable semejanza y congruencia entre las valoraciones emitidas por los estudiantes y evaluadores áulicos, no siendo igual en los docentes, donde fue discordante, lo que puede estar determinado por una postura menos crítica sobre su propia práctica y/o una falta de feedback o retroalimentación sistemática que resulta necesaria durante el proceso, para poder hacer los ajustes necesarios en la marcha.

Las mediciones hechas de medias, varianzas y del Alpha de Cronbach son coherentes y mostraron fiabilidad, consistencia y validez. Esto se reafirmó a través del análisis documental efectuado, donde se apreció una notable coherencia.

Los indicadores considerados, mostraron factibilidad y viabilidad al ser sometidos al análisis estadístico, permitiendo hacer interpretaciones cualitativas fundamentales y productivas.

Alvarado, P., & Nuñez, C. (2018). La evaluación como referente de calidad educativa. El caso del Municipio de Sopetran, Antioquia (Colombia). Revista Espacios, 39(15), 8–15.

Anijovich, R. (2017). La evaluación formativa en la enseñanza superior. Voces de La Educación, 2(2), 31–38.

Arribas, J. M., & Estebaranz, J. M. A. (2017). La evaluación de los aprendizajes. Problemas y soluciones. Profesorado, 21(4), 381–404. Recupardo de https://doi.org/10.1017/CBO9781107415324.004

Barriga-Díaz, A. (2013). El examen: textos para su historia y debate. Madrid: Palaza y Valdes.

Blanco, N., & Pirela, J. (2016). La complementariedad metodológica: Estrategia de integración de enfoques en la investigación social. Espacios Públicos, 19(45), 97–111. Recuperado de https://doi.org/10.1177/1528083714559566

Cabra-Torres, F. (2010). El diálogo como fundamento de comunicación ética en la evaluación. Educación y Educadores, 13(2), 239–252.

Castaño, A., Ramos, P., & García, A. (2017). Evaluación del aprendizaje basado en problemas y examen final: diferencias en la percepción de justicia y el desarrollo de competencias. IV Congreso Internacional Sobre Aprendizaje, Innovación y Competividad (CINAIC 2017), 231–236. Recuperado de https://doi.org/10.26754/CINAIC.2017.000001

CES. Reglamento del Sistema de Evaluación Estudiantil, Pub. L. No. RPC-SO-29-No.489-2016 (2016). Ecuador.

Contreras, G. (2010). Diagnóstico de dificultades de la evaluación del aprendizaje en la universidad: un caso particular en Chile Diagnosing Learning Assessment Difficulties at the University Level: A Specific Case in Chile. Educación y Educadores, 13(2), 219–238.

Cuenya, L., & Ruetti, E. (2010). Controversias epistemológicas y metodológicas entre el paradigma cualitativo y cuantitativo en psicología. Revista Colombiana de Psicología, 19(2), 271–277.

Escobar-Pérez, J., & Cuervo-Martínez, A. (2008). Validez de Contenido y Juicio de Expertos: Una aproximación a su utilización. Avances de Medición, 6, 27–36.

Escudero, T. (2003). From tests to current evaluative research. Revista Electrónica de Investigación y Evaluación Educativa, 9, 11–43.

Estupiñán, J., Carpio, D., del Rocío, J., & Romero, V. (2016). Participación de los estudiantes en el proceso de enseñanza-aprendizaje en la Educación Superior de Ecuador. Revista Magazine de Las Ciencias, 1(2), 35–50.

Feu, J., Simó, N., Serra, C., & Canimas, J. (2016). Dimensiones, características e indicadores para una escuela democrática. Estudios Pedagógicos (Valdivia), 42(3), 449–465.

Godoy, M. F. (2015). Las preguntas de docentes como estrategia para el desarrollo de habilidades cognitivas de los estudiantes en la asignatura Historia, Geografía y Ciencias Sociales. Foro Educacional UCSH, (24), 57–76.

Gómez, V., Monjas, R., Gómez, J., López, J., & Martín, J. (2006). La Evaluacion en Educacion Fisica: Revisión de modelos tradicionales y planteamiento de una alternativa. La Evaluación Formativa y compartida. Retos: Nuevas Tendencias En Educación Física, Deporte y Recreación, 4(10), 31–41.

González. (2000). La Evaluación del Aprendizaje en la Enseñanza Universitaria. (CEPES. Universidad de la Habana, Ed.). Habana.

González Alonso, J., & Pazmiño Santacruz, M. (2015). Cálculo e interpretación del Alfa de Cronbach para el caso de validación de la consistencia interna de un cuestionario , con dos posibles escalas tipo Likert. Revista Publicando, 2(1), 62–77. Recuperado de https://doi.org/10.11919/j.issn.1002-0829.215010

Gorina, A., & Alonso, I. (2017). Perfeccionando el procesamiento de la información en investigaciones pedagógicas desde una relación metodológica cualitativa-cuantitativa. Revista Encuentros, 5(2), 189–226. Recuperado de https://doi.org/DOI: http://dx.doi.org/10.15665/re.v15i2.1201

Green, S., Smith, J., & Brown, K. (2007). Using Quick Writes as a Classroom Assessment Tool: Prospects and problems. Journal of Educational Research & Policy Studies, 7(2), 38–52.

Guerra, S. (2003). Dime como evaluas y te diré que tipo de profesional eres. Revista Enfoques Educativos, 5(1), 69–80.

Hamodi, C., & López, A. T. (2012). La evaluación formativa y compartida en la Formación Inicial del Profesorado desde la perspectiva del alumnado y de los egresados. Psychology, Society, & Education, 4(2), 103–116.

Hamodi, C., López, A. T., & López, V. M. (2015). Perceptions of students, graduates and teachers on learning systems evaluation. @Tic. Revista D’Innovació Educativa. Universidad de Valencia, 0(14). Recuperado de https://doi.org/10.7203/attic.14.4175

Heras, V. E. (2017). LA formación pedagógica del docente universitario. Palermo Business Review, 65–74.

Hernández, M. (2006). Indicadores del aprendizaje al centro de la mira : argumentos y resultados de una experiencia Desarrollo. Revista Iberoamericana de Educación, 37(6), 1–12.

Hernández, M. (2015). Estrategia de Intervencion pedagógica para la transformación de las concepciones y prácticas evaluativas de los profesores. (E. GRIN, Ed.).

Hernández, M. (2017). Why has it been so difficult to transform evaluation practices of learning in the educational context? A critical essay on a pedagogical pathology still to be treated. Revista Electronica Educare, 21(1). Recuperado de https://doi.org/10.15359/ree.21-1.21

Hernández, M., & Mola, M. (2016). Prácticas evaluativas en la Universidad Deportiva del Sur, Venezuela. Revista Cubana de Educación Superior, 35(2), 4–15.

Hernández, M., Villarroel, V., & Zambrano, J. (2019, en prensa). Dimensiones e Indicadores para la metaevaluación del aprendizaje: Reflexión y propuesta al campo teórico de la evaluación en la Educación Superior. Revista Cubana de Educación Superior, (1).

Hidalgo, N., & Murillo, F. J. (2017). Las Concepciones sobre el Proceso de Evaluación del Aprendizaje de los Estudiantes. REICE. Revista Iberoamericana Sobre Calidad, Eficacia y Cambio En Educación, 15.1(2017), 107–128. Recuperado de https://doi.org/10.15366/reice2017.15.1.007

Ibarra, M. S., & Rodríguez, G. (2010). An approach to the dominant discourse of learning assessment in higher education. Revista de Educación, (351), 385–407.

Leyva, Y. E. (2010). Evaluación del Aprendizaje: Una guía práctica para profesores. Obtenido de Universidad Nacional Autónoma de México (UNAM).

Martín, E., & Martínez, F. (2008). Avances y desafíos en Evauación Educativa. (Fundación Santillana.OEI, Ed.), Metas Educativas 2021. La Educación que queremos para la generación de los Bicentenarios. (Vol. 5). Madrid. Recuperado de https://doi.org/10.1038/ncpcardio1063

Martínez, L., Santos, M., & Castejón, F. (2017). Percepciones de alumnado y profesorado en Educación Superior sobre la evaluación en formación inicial en educación física. Retos: Nuevas Tendencias En Educación Física, Deporte y Recreación, (32), 76–81.

MEE. (2017). Estándares de Aprendizajes. (S. de F. E. M. de E. de Ecuador., Ed.). Quito.

Monereo, C., & Lemus, C. (2010). Dime como evalúas y te diré como aprender tus alumnos. Aula Innovación Educativa, 190(March 2010), 56–59.

Mora, A. I. (2004). La Evaluación Educativa: Conceptos, períodos y modelos. Revista Electrónica “Actualidades Investigativas, 4(2), 1–28.

Moscoso, F., & Hernández, A. (2015). No Title. Revista Cubana de Educación Superior, 34(3), 140–154.

Muskin, J. (2015). Evaluación del aprendizaje del estudiante y el currículo : problemas y consecuencias para la política, el diseño y la aplicación. MINEDU.

Orostegui, M. A., Lastre Amell, G., & Gaviria García, G. (2015). The ethics of professor relegates formation in student values. Theoretical vision. Educación y Humanismo, 17(29), 120–133. Recupardo de https://doi.org/10.17081/eduhum.17.29.1257

Pérez, L. O., Mora, A., Triana, B. M., & Garzal, E. J. (2015). Reflexiones conceptuales sobre la evaluación del aprendizaje. Didasc@lia: Didáctica y Educación, VI, 149–168.

Prieto, M., & Contreras, G. (2008). Las Concepciones Que Orientan Las Practicas Evaluativas De Los Profesores: Un Problema a Develar. Estudios Pedagógicos (Valdivia), 34(2), 245–262. Recuperado de https://doi.org/10.4067/S0718-07052008000200015

Ramos, C. A. (2015). Los paradigmas de investigación científica. Avances En Psicología, 23(1), 9–17.

Ravanal, E., López-Cortés, F., & Rodríguez, L. (2018). Creencias de profesores chilenos de biología sobre la preparación de la enseñanza. Revista Eureka Sobre Enseñanza Y Divulgación de las Ciencias, 15. Recupardo de https://doi.org/https://doi.org/10.25267/Rev_Eureka_ensen_divulg_cienc.2018.v15.i3.3601

Renes, P., & Martínez, P. (2016). Una mirada a los estilos de enseñanza en función de los estilos de aprendizaje. Revista de Estilos de Aprendizaje, 9(18), 224–243.

Ricoy, M. C., & Femández-Rodríguez, J. (2013). La percepción que tienen los estudiantes universitarios sobre la evaluación: Un estudio de caso. Educacion XX1, 16(2), 321–342. Recupardo de https://doi.org/10.5944/educxx1.16.2.2645

Rodríguez-Espinosa, H., Restrepo-Betancur, L. F., & Luna-Cabrera, G. C. (2016). Percepción del estudiantado sobre la evaluación del aprendizaje en la educación superior Students’ Perception about Learning Assessment in Higher Education. Revista Electrónica Educare (Educare Electronic Journal), 20(3), 1409–4258. Recuperado de https://doi.org/10.15359/ree.20-3.18

Rodríguez, G., Ibarra, M., Gallego, B., Gómez, M., & Quesada, V. (2012). La voz del estudiante en la evaluación del aprendizaje: un camino por recorrer en la universidad. RELIEVE - Revista Electrónica de Investigación y Evaluación Educativa, 18(2), 1–21. Recupardo de https://doi.org/10.7203/relieve.18.2.1985

Romero, R., Castejón, F. J., & López, V. (2015). Divergencias del alumnado y del profesorado universitario sobre las dificultades para aplicar la evaluación formativa. RELIEVE - Revista Electronica de Investigacion y Evaluacion Educativa, 21(1), 1–16. Recuperado https://doi.org/10.7203/relieve.21.1.5169

Salgado, G., Bauza, B., & González, M. (2017). La evaluación integradora en el proceso de enseñanza aprendizaje de la Didáctica de la biología. Revista Boletín REDIPE, 6(8), 49–56.

SNNA. SENESCYT. (2013). Programa metodológico.Proyecto Integrador de Saberes (Pis). Secretaría Nacional de Educación Superior, Ciencia, Tecnología e Innovación.

Suárez-Villao, M. ., Domínguez, N., & Gallegos, I. (2018). Proyecto MEVALAP-UPSE: percepciones y reflexiones de la evaluación del proceso enseñanza aprendizaje en Facultad de Ciencias Sociales y de la Salud. Polo Del Conocimiento. Reviista Multidisciplinar de Innovación y Estudios Aplicados, 3(27), 153–175. Recuperado de https://doi.org/https://doi.org/10.23857/pocaip

Teddlie, C., & Tashakkori, A. (2011). Mixed Methods research. The Sage Handbook of Qualitative Research, 285–300.

Trillo, F., & Porto, M. (1999). La Percepción de los estudiantes sobre su evaluación en la Universidad. Un estudio en la Facultad de Ciencias de la Educación. Innovación Educativa.

UNOPAC. (2017). Informe de balance sobre la evaluación del desempeño docente 2017-1, 2017-2. Documento Interno Institucional. La Libertad.

Ureña, J. (2016). El examen, instrumento de poder y control en la educación: Díaz Barriga. Odiseo. Revista Electrónica de Pedagogía.

Vaillant, D., & Rodríguez, E. (2018). Perspectivas de la UNESCO y la OEI sobre la calidad de la Educación. In Calidad de la Educación en Iberoamérica: Discursos, políticas y prácticas (pp. 136–154). Madrid: DYKINSON S. L.

Van der Bijl, B. (2015). La evaluación de carreras universitarias en Ecuador ¿Desde qué concepción de Educación? Anales. Revista de La Universidad de Cuenca, Tomo 52, 9–22.

Virla, M. (2010). Confiabilidad y coeficiente Alpha de Cronbach. Telos, 12(2), 248–252. Recuperado de https://doi.org/10.1109/IGARSS.2004.1370608

Yunga-Godoy, D., Loaiza, M., Ramón, L., & Puertas, L. (2016). No Title. Profesorado. Revista de Currículum y Formación Del Profesorado, 20(3), 313–333.

1. Doctor en Ciencias Pedagógicas. Máster en Enseñanza de las Ciencias en la Educación Superior. Docente-Investigador. Colaborador del Vicerrectorado Académico. Director del Proyecto MEVALAP-UPSE. Universidad Estatal Península de Santa Elena, Ecuador. mhernandeznodarse@gmail.com

2. Máster en Docencia y Gerencia de la Educación Superior. Coordinador de Capacitación del Vicerrectorado Académico. Docente-Inv. Universidad Estatal Península de Santa Elena, Ecuador. Freddytigre2014@gmail.com

3. Máster en Gerencia Educativa. Programador informático y de Sistemas. Docente-Investigador. Universidad Estatal Península de Santa Elena, Ecuador. yruiz@upse.edu.ec